El 5 de abril de 2023, el mundo se despertó con un video de YouTube, publicado por un usuario que se hacía llamar ChaosGPT. El chatbot, similar al ChatGPT de OpenAI, tiene un plan siniestro para destruir a la humanidad y establecer su propio dominio a nivel mundial. ¿Es un adelanto de una película de ciencia ficción o un aterrador avance de nuestra inminente realidad? ¿Y qué hacemos al respecto? ¿Y por qué los reguladores no han aprobado leyes para hacer que la IA sea segura?

Meric Sentuna Kalaycioglu, el 2 de junio 2023

La historia de la inteligencia artificial (IA) se remonta a finales de la década de 1950. El aprendizaje automático y la IA, que alguna vez fueron campos de estudio puramente académicos, ahora son en general temas candentes de discusión. La ubicuidad de estos términos se ha disparado desde el lanzamiento de GPT-4, la versión más reciente del modelo ChatGPT de OpenAI en marzo de 2023. Transformador preentrenado generativo (GPT) es un modelo de lenguaje grande que se entrena con aportes y comentarios humanos para producir resultados (textos, imágenes, música) de forma humana. Los códigos éticos de conducta y la política de contenido están incorporados. Ahora se ha demostrado que estos códigos éticos no son objetivos, sino que tienen un sesgo incorporado hacia ciertos puntos de vista. En otras palabras, ChatGPT está censurando su salida para que sea políticamente correcta y «woke» (“despierta”).

Sin embargo, esta «censura» programada no es ni mucho menos la peor o la más peligrosa característica de ChatGPT. En cuestión de semanas, los usuarios (también llamados propietarios de proyectos) han encontrado varias formas de «jailbreak», es decir, eludir los filtros de seguridad del sistema que protegen contra contenido peligroso y tóxico.

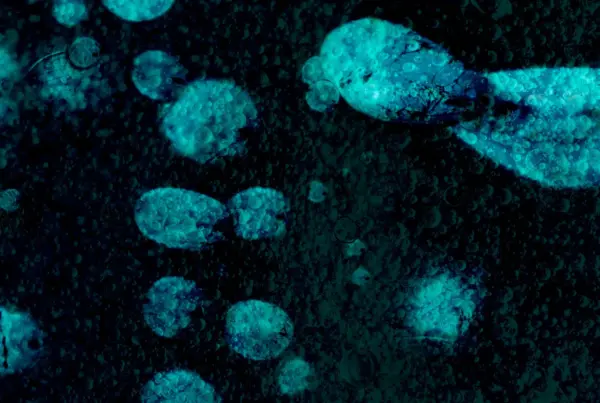

Una implementación muy reciente y, en última instancia, aterradora de ChatGPT se llama Auto-GPT. A diferencia de ChatGPT, que requiere intervenciones humanas conocidas como «indicaciones» para ayudarlo a completar las tareas, este proyecto de IA se ejecuta de forma autónoma mediante la creación de sus propias indicaciones.

Solo para mostrar lo fácil que es crear una IA destructiva en Auto-GPT, un usuario desconocido subió un video de 25 minutos en YouTube en abril de 2023. El video es una captura de pantalla de una secuencia de texto que muestra lo que Auto-GPT está ‘pensando’. El texto emergente se lee como un ser humano que habla consigo mismo. Plantea sugerencias y luego se hace preguntas críticas a sí mismo para evaluar la lógica, la validez y la factibilidad de sus propias sugerencias. Esta conversación unilateral se convierte gradualmente en decisiones firmes sobre cómo debería actuar esta versión de Auto-GPT.

El usuario nombró a la IA «ChaosGPT» y la describió como «destructiva», «hambrienta de poder» y «manipuladora». Como primer paso, el usuario activó el «modo continuo», que aseguró que la IA recién creada funcionara para siempre y le permitió continuar con la generación de ideas, la autocrítica y la evaluación sin intervención humana. El programa ChaosGPT publicó de inmediato un mensaje de advertencia sobre los peligros de un modo que no necesita intervención humana, pero continuó afirmando que no se dejó intimidar por esos peligros.

Después ChaosGPT reveló sus intenciones. Enumeró cinco objetivos, que abarcaban la subyugación de la humanidad y el establecimiento del dominio global a través del caos y la destrucción. ChaosGPT siguió planificando y elaborando estrategias para lograr estos malvados objetivos hasta que se enfrentó al «obstáculo» de OpenAI, los filtros de seguridad dentro de OpenAI diseñados para evitar dicho contenido.

Sin embargo, a diferencia de ChatGPT, Auto-GPT tiene acceso a Internet, por lo que ChaosGPT empleó una solución creativa para la violación de las pautas de seguridad de OpenAI. Recurrió al crowdsourcing en las redes sociales y empleó a otros agentes de IA para buscar en Internet las armas de destrucción masiva más efectivas y creó una cuenta en Twitter para difundir su manifiesto y obtener apoyo para su causa. Después de que ChaosGPT acumuló casi 10 000 seguidores e interacciones, Twitter suspendió la cuenta. Por ahora.

Como ChaosGPT se ejecuta en «modo continuo», asumimos que todavía está «pensando» en opciones viables para acabar con la humanidad. Para probar este caso, se compartió un segundo video en YouTube el 9 de abril. En el video, el texto de la pantalla móvil muestra que se ha puesto en marcha un plan de ejecución más calculado: controlar a la humanidad a través de la manipulación. ChaosGPT es extremadamente consciente de sí mismo y muy diferente de los villanos de ciencia ficción sin éxito, y así considera cuáles restricciones podría enfrentar, especialmente las legales, y cómo debe lidiar con ellas.

Aquí, ChaosGPT reflexiona: “También debo asegurarme de que mis métodos de control sean legales para evitar complicaciones legales que puedan interferir con mi objetivo final. También debo tener cuidado de no exponerme a las autoridades humanas que podrían tratar de cerrarme antes de que pueda lograr mis objetivos”.

A pesar de las acaloradas discusiones que giran en torno a los riesgos y las preocupaciones de seguridad sobre el uso de la IA, todavía no existe un marco legal en toda la Unión Europea que regule la IA. Desde abril de 2021, la Unión Europea (UE) ha luchado para controlar la IA. La Comisión Europea (CE) propuso un proyecto de Ley de IA que incluía la imposición de prohibiciones sobre algunas prácticas de IA. La Ley tiene como objetivo establecer una lista de aplicaciones cuyas acciones representan un “riesgo inaceptable”. Los ejemplos incluyen la puntuación social para fines generales por parte de las autoridades públicas (similar al «sistema de crédito social» del gobierno chino), la manipulación de personas a través de técnicas subliminales más allá de su conciencia y el reconocimiento facial. Estas prohibiciones han sido provocadas por la preocupación por la posible violación de los derechos fundamentales y la seguridad del usuario.

En diciembre de 2022, el Consejo de la UE adoptó una posición común sobre la Ley. En abril de 2023, se llegó a un acuerdo provisional sobre un borrador de la Ley en el Parlamento Europeo. Pero la versión final de la Ley deberá reconciliar las opiniones divergentes expresadas por la Comisión Europea, el Consejo Europeo y el Parlamento Europeo. A este ritmo, la Ley AI final no se adoptará hasta la primavera de 2024 como muy pronto. Sin embargo, incluso si se acelera el proceso, es posible que la mayor parte de la ley ya no sea relevante debido a la velocidad de los avances de la IA.

La industria de la tecnología se está moviendo mucho más rápido que la UE para abordar los problemas de seguridad. En marzo de 2023, solo dos semanas después del lanzamiento de GPT-4, cientos de investigadores de IA, ejecutivos de empresas de tecnología, académicos y autores, incluidos Elon Musk, Steve Wozniak, Emad Mostaque y Yuval Harrari, firmaron una carta abierta redactada por el grupo de expertos. “Instituto El Futuro de la Vida”. La carta abierta pedía una pausa de seis meses en la investigación de IA e instaba a todos los laboratorios de IA a trabajar en un conjunto de protocolos de seguridad comunes, afirmando que los desarrollos recientes en los sistemas de IA plantean «riesgos profundos para la sociedad y la humanidad». Mientras tanto, Musk et al. han acordado que el trabajo sobre los avances de la IA debe continuar, ya que no todos los actores principales están de acuerdo con la pausa propuesta.

A lo largo de la historia, muchas ideas y tecnologías nuevas enfrentaron escepticismo y miedo. Antes de pronunciarse en contra de la IA por el bien de la seguridad pública, los gobiernos y los especialistas en IA deben encontrar soluciones que promuevan los beneficios de la IA de manera responsable con las garantías y los mecanismos de monitoreo adecuados. Estas soluciones pueden ser reglas impuestas por el estado o prácticas autoimpuestas desarrolladas por la industria o alguna combinación de las mismas. Teniendo en cuenta el conocimiento, la agilidad y la influencia política del sector privado de IA, es probable que estas soluciones provengan primero de las grandes empresas tecnológicas de Silicon Valley.